在大模型快速發展的今天,越來越多的模型開始具備“深度思考能力”。比如,DeepSeek-R1系列模型通過引入特別的提示詞結構:先<think>,再<answer>,使得模型在回答問題之前先進行“深度思考”,生成一整段包含反復自我反思、自我驗證的推理過程,然后再給出答案。這一過程顯著提升了模型解決復雜問題的能力,但也同時帶來了“過度思考”的問題,即模型在解決簡單任務時也會生成冗余的推理語句。例如提問 “2+3等于幾”,模型卻要從自然數定義講起,列出加法交換律,甚至反復試錯,最后才輸出答案是5。這種不必要的“過度思考”現象在推理模型中廣泛存在。

針對這一問題,中國科學院自動化研究所聯合鵬城實驗室提出了一種高效的推理策略AutoThink,賦予推理大模型根據題目難度自主切換思考模式的能力:通過所設計的提示詞和多階段強化學習,引導大模型自主決定是否進行深度思考。

具體而言,AutoThink提出了一個簡單而有效的方案,它涉及兩個核心技術點:

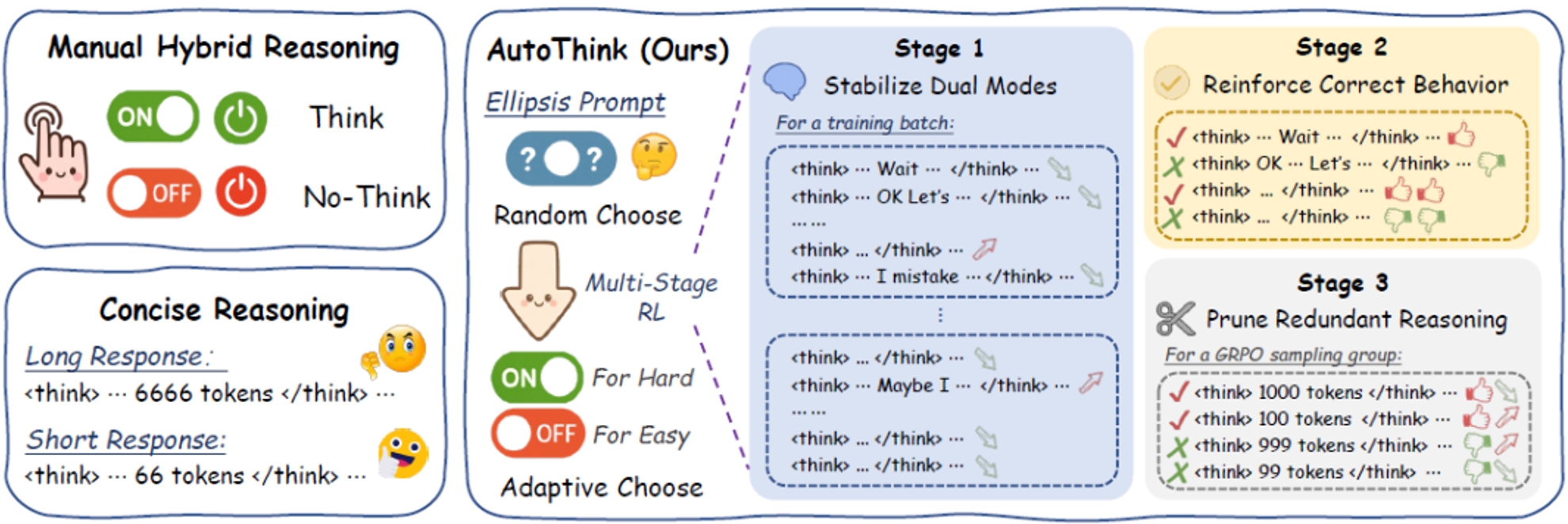

(1)最小提示干預,通過一個添加省略號的Ellipsis?Prompt,激活模型隨機切換思考模式的能力;

(2)多階段強化學習,通過三階段強化學習,模型學會自主根據問題難度切換思考模式。第一階段讓模型穩定地出現快慢兩種思考模式,其中“快思考”用于解決簡單問題,而對于復雜問題則使用“慢思考”;第二階段對快慢思考行為進行優化,提高兩種模式下正確回答的能力;第三階段對快慢思考的思維鏈輸出進行精煉。經過這個階段的訓練后,模型不再隨機地決定是否深入思考,而是根據問題難度自主選擇思考模式。

通過這兩者的結合,模型具備了類似人類的快慢思考能力:簡單問題直截了當,復雜問題深度推理,真正做到“按需思考”。如圖所示,相比之下,傳統方法要么手動控制思考模式,要么不區分題目難度,一味地采用簡潔推理方法壓縮推理過程。

AutoThink與手動控制和簡潔推理方法的核心差異:根據難度自主切換思考模式

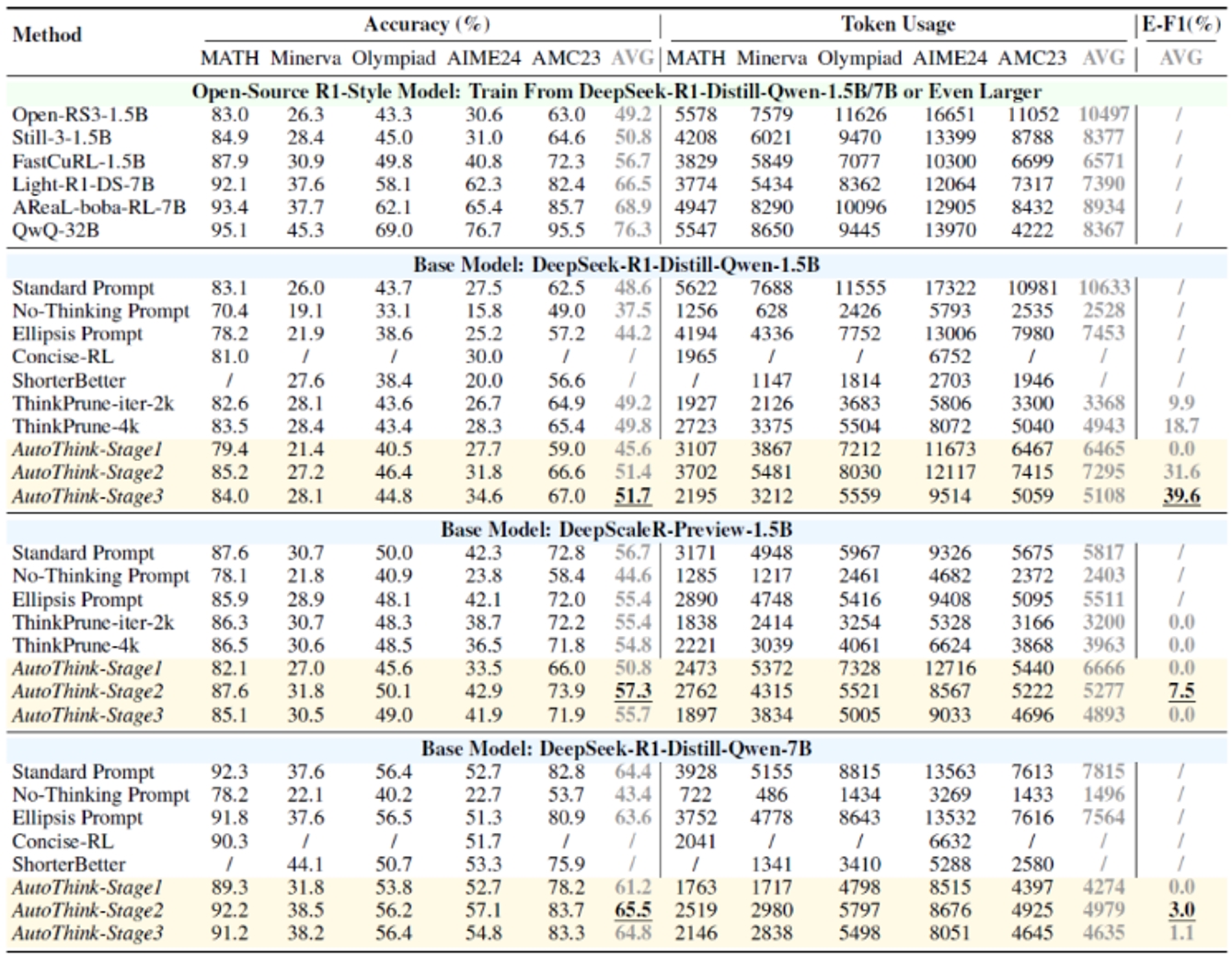

研究團隊在多個數學Benchmark和基礎模型(R1-Style)上驗證了AutoThink。實驗結果顯示:AutoThink不僅能提升R1蒸餾基模的性能,同時可減少約40%的推理Token消耗,如下表所示。相比之下,大部分開源模型性能增強的代價是推理長度(思考過程)的成倍增長;而簡潔思考的模型性能相比于基礎模型幾乎無提升甚至下降。特別地,即使在已經過大量強化學習后訓練的DeepScaleR上,AutoThink依然能額外節省10%的Token消耗。

不同模型和Benchmark上的準確度和推理長度對比

AutoThink提供了一種簡單而有效的推理新范式,即通過省略號提示配合三階段強化學習,引導模型不再“逢題必思”,而是根據問題難度自主決定是否思考、思考多少。在多個數學數據集上,AutoThink實現了優異的準確率–效率平衡,既提升性能,又節省算力,展示出很強的適應性和實用性。

AutoThink已集成于一站式智能科研平臺ScienceOne,并將用于訓練ScienceOne的基座大模型S1-Base。研發團隊表示,讓大模型“更聰明地思考、更簡潔地表達”,是未來科學基礎大模型演進的重要方向。

來源:中國科學院自動化研究所

資訊頻道

資訊頻道